Vulnerabilidades no Nvidia Triton Inference Server colocam ecossistema de IA em risco

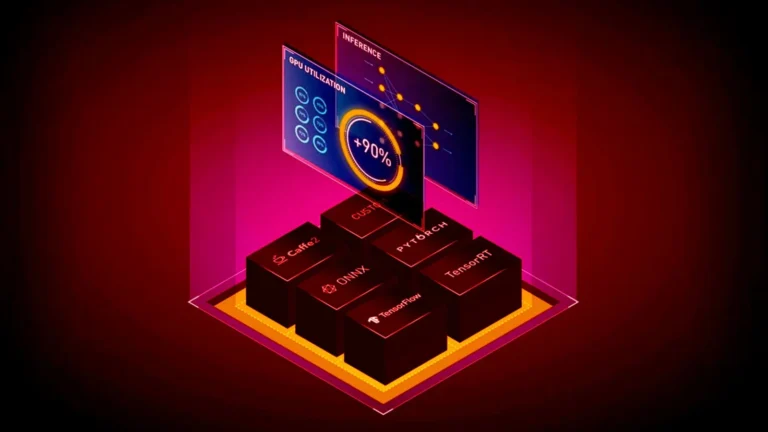

Pesquisadores da Wiz Research identificaram três vulnerabilidades de alta periculosidade no Nvidia Triton Inference Server, plataforma de código aberto usada para testar e executar modelos de inteligência artificial em larga escala.

A Nvidia confirmou os problemas em 4 de agosto de 2025 e publicou correções na versão 25.07 do software. Embora não haja relatos de exploração ativa, especialistas recomendam a atualização imediata.

Quem descobriu as falhas e quando

A Wiz Research, equipe de análise de segurança em nuvem, conduziu testes que revelaram as brechas. O relatório foi repassado à Nvidia, que validou os achados e divulgou os detalhes no início desta semana.

As falhas afetam diretamente o backend Python do Triton, componente responsável por interligar frameworks como PyTorch e TensorFlow aos recursos de CPU e GPU.

Detalhamento das três vulnerabilidades confirmadas

CVE-2025-23319 – escrita fora dos limites

Classificada com pontuação 8.1 no CVSS, a falha permite que um invasor remoto provoque erro de escrita fora dos limites, condição que pode resultar em execução arbitrária de código no servidor.

CVE-2025-23320 – estouro de memória e negação de serviço

Com pontuação 7.5, este problema possibilita o envio de requisições excessivamente grandes. O consumo anormal de memória leva à negação de serviço e serve de porta de entrada para ataques subsequentes.

CVE-2025-23334 – vazamento de informações confidenciais

Marcada com 5.9 no CVSS, a falha envolve envio de requisição específica capaz de expor trechos de memória do sistema, revelando dados sensíveis que deveriam permanecer privados.

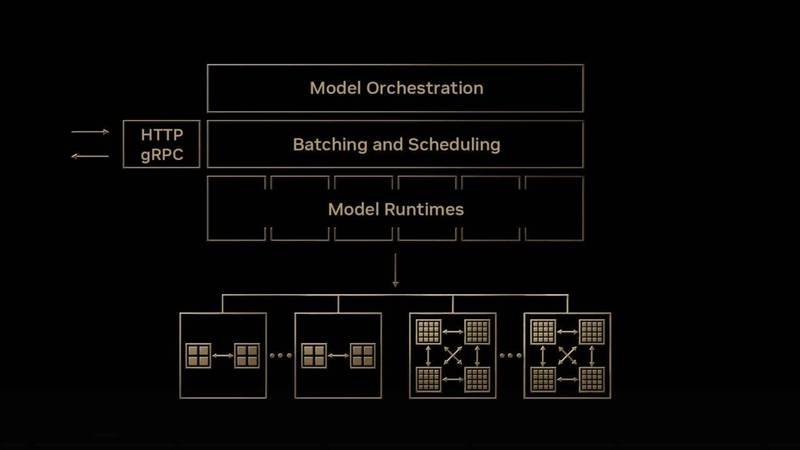

Como as brechas podem ser encadeadas

Nos testes da Wiz Research, o ataque começou pela CVE-2025-23320, que gerou o erro de escrita fora dos limites responsável por vazar o nome exclusivo de IPC (Inter-Process Communication) do backend Python.

Com esse identificador em mãos, o invasor pôde explorar a CVE-2025-23319 para assumir controle do processo e, na sequência, recorrer à CVE-2025-23334 para extrair informações adicionais da memória.

O encadeamento concede controle total do servidor, permitindo execução de código malicioso, roubo de modelos de IA e manipulação das respostas geradas pela plataforma.

Impacto potencial nas organizações

Empresas que utilizam o Triton para inferência de IA/ML podem sofrer exposição de dados confidenciais, perda de propriedade intelectual e criação de pontos de apoio para movimentação lateral dentro da rede corporativa.

Segundo a Wiz, a gravidade aumenta em ambientes que executam várias cargas de trabalho de IA compartilhando o mesmo servidor, cenário comum em laboratórios de pesquisa e provedores de nuvem.

Imagem: tecmundo.com.br

Medidas de mitigação recomendadas

Atualização para a versão 25.07

A Nvidia liberou a versão 25.07 do Triton Inference Server, que corrige integralmente as três vulnerabilidades. Usuários devem aplicar a atualização imediatamente em todos os ambientes de produção e testes.

Revisão de configurações de segurança

Administradores são orientados a limitar o tamanho das requisições aceitas pelo backend Python, habilitar controle de acesso estrito e monitorar logs em busca de atividades incomuns.

Segmentação de rede e princípio do menor privilégio

Isolar servidores de inferência de IA em redes segmentadas reduz a superfície de ataque. Adotar o princípio do menor privilégio impede que um eventual comprometimento se espalhe para outras partes da infraestrutura.

Por que a descoberta é relevante para o setor de IA

Aplicações de inteligência artificial dependem de grandes volumes de dados e modelos valiosos. Brechas em camadas de inferência afetam não apenas integridade e confidencialidade, mas também confiabilidade dos resultados apresentados aos usuários finais.

A identificação rápida e a divulgação responsável ilustram a importância de processos de segurança voltados a ambientes de aprendizado de máquina, que ganham escala em setores como saúde, finanças e indústria.

Próximos passos para desenvolvedores e empresas

Além de atualizar o Triton, desenvolvedores devem revisar práticas de codificação segura em modelos customizados carregados no backend Python. Auditorias periódicas de terceiros especializados podem antecipar novas vulnerabilidades.

Organizações que mantêm cadeias de suprimentos de IA complexas devem integrar o gerenciamento de patches a fluxos de DevSecOps, garantindo correções automáticas e testes regressivos antes da implantação.

Conclusão: importância da resposta rápida a vulnerabilidades

A descoberta das falhas CVE-2025-23319, CVE-2025-23320 e CVE-2025-23334 reforça a necessidade de monitorar continuamente componentes de IA. A correção oficial já está disponível, e a adoção imediata reduz o risco de comprometer ativos críticos.

Com a evolução constante de ataques direcionados a modelos de aprendizado de máquina, a colaboração entre pesquisadores de segurança e fornecedores permanece essencial para proteger o ecossistema.

{

“@context”: “https://schema.org”,

“@type”: “NewsArticle”,

“headline”: “Falhas críticas expõem usuários do Nvidia Triton Inference Server; atualização 25.07 corrige brechas”,

“datePublished”: “2025-08-05T18:45:00-03:00”,

“dateModified”: “2025-08-05T18:45:00-03:00”,

“author”: {

“@type”: “Person”,

“name”: “Redação”

},

“publisher”: {

“@type”: “Organization”,

“name”: “Portal de Tecnologia”,

“logo”: {

“@type”: “ImageObject”,

“url”: “https://www.exemplo.com/logo.png”

}

},

“description”: “Pesquisadores identificam três vulnerabilidades no Nvidia Triton Inference Server que permitem controle remoto e vazamento de dados. Atualização 25.07 corrige as falhas.”

}